Cette page a été traduite automatiquement.

Merci de bien vouloir compléter un sondage de 1 minute concernant la qualité de cette traduction.

Caméra à photon unique permettant la lecture vidéo à n'importe quelle échelle de temps

L'acquisition de données extrêmes ouvre la voie à de nouvelles applications de Computer Vision

Des chercheurs en imagerie computationnelle de l’Université de Toronto ont capturé un signal étrange avec leur caméra spécifique. En effectuant des expériences en laboratoire avec la caméra, une diode à avalanche à photon unique (SPAD), le Toronto Computational Imaging Group a détecté un scintillement inexpliqué de 80 kilohertz (kHz).

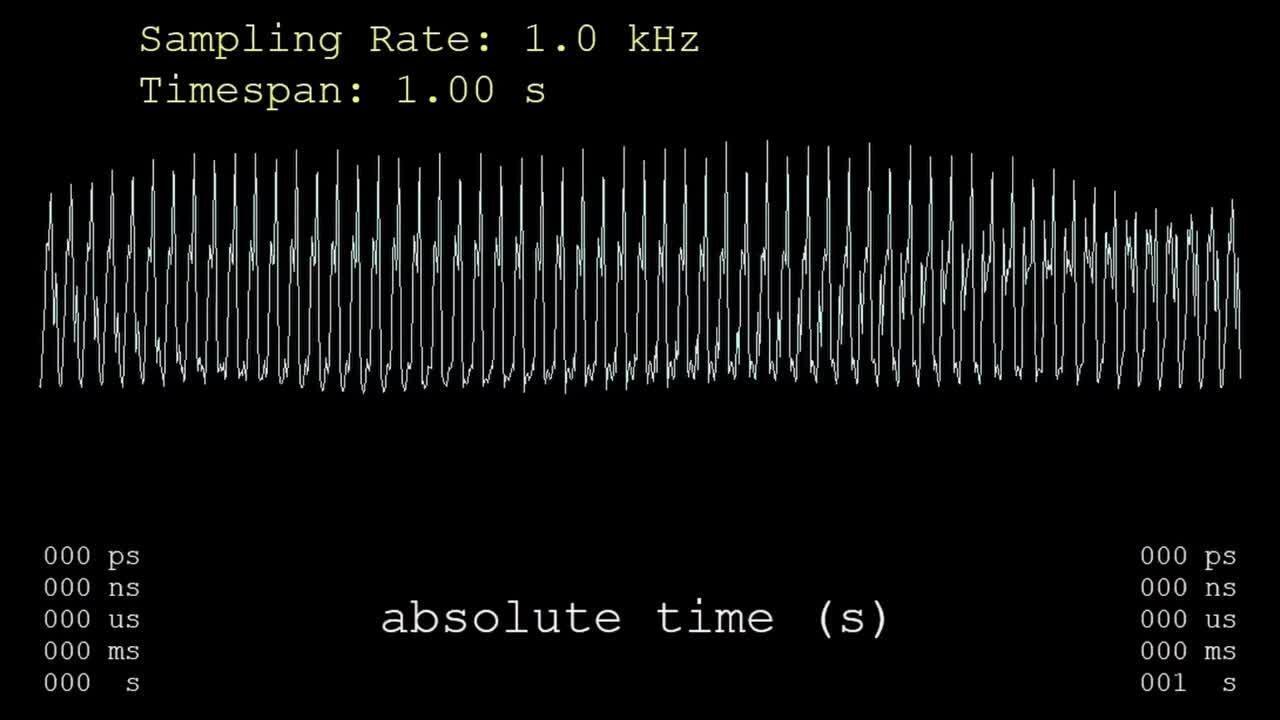

À l’aide de leur puissant capteur d’imagerie autonome, ils ont détecté chaque photon individuellement à son arrivée, provenant de diverses sources lumineuses, et ont enregistré son heure d’arrivée précise, au billionième de seconde près. Après avoir acquis toutes les données pour chaque pixel, l’équipe a appliqué un algorithme qui leur a permis de créer des vidéos reconstituant la lumière à tout moment sur une plage extrême, allant de quelques secondes à quelques picosecondes.

« Vous pouvez zoomer à l'échelle de temps que vous souhaitez et lire une vidéo : 30 images par seconde, mille, un million, un milliard », a déclaré Kyros Kutulakos, professeur d'informatique à l'Université de Toronto. « Il n’est pas nécessaire de connaître à l’avance l’échelle de temps à laquelle on souhaite observer un phénomène. »

Avant cela, les chercheurs pouvaient capturer la propagation de la lumière à travers un environnement sur quelques nanosecondes, mais ne pouvaient pas simultanément imager des événements incroyablement rapides et lents.

Les technologies existantes sont spécialisées dans des régimes temporels particuliers, explique le professeur adjoint David Lindell, collègue de Kutulakos. Les caméras conventionnelles à grande vitesse peuvent atteindre des vitesses allant jusqu'à environ 1 million d'images par seconde, ce qui est suffisamment rapide pour capturer une balle lancée à toute vitesse ; mais passer à des milliards ou des billions d'images par seconde nécessite des caméras très spécialisées qui ne peuvent pas capturer des événements durant plus d'une microseconde environ.

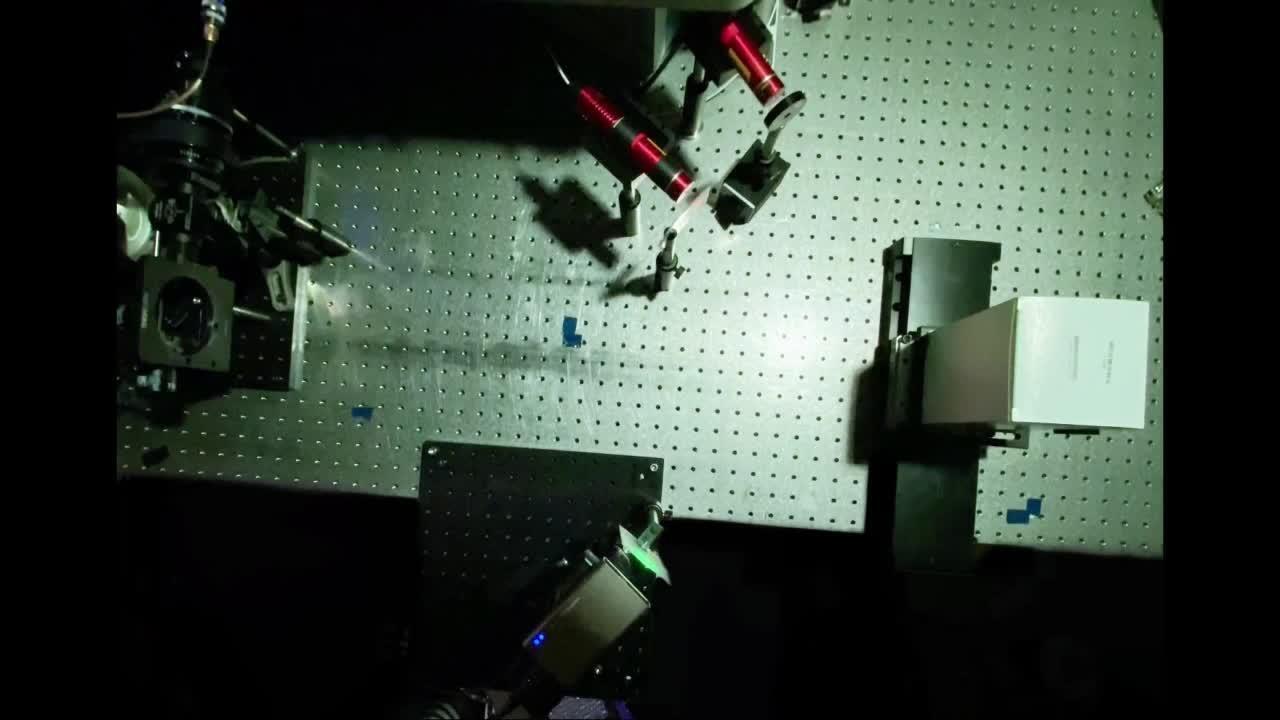

Grâce à un capteur d'imagerie à déclenchement libre, chaque photon individuel provenant de différentes sources lumineuses est détecté et l'heure d'arrivée précise est enregistrée. (Crédit : Université de Toronto)

L'équipe de l'Université de Toronto a utilisé MATLAB® pour acquérir les données d'horodatage (timestamp) des photons individuels et pour contrôler les composants mobiles dans leurs installations. Le groupe a surnommée sa technique d’imagerie, « microscope du temps ».

Le SPAD à pixel unique dispose d'une tête de détection de 60 millimètres sur 60 millimètres avec un petit capteur au milieu. Lorsque le SPAD a détecté un signal étrange de 80 kHz, les chercheurs se sont d’abord demandé s’ils n’avaient pas simplement rencontré un artefact. En y regardant de plus près, l’équipe a découvert la source.

« Il s’avère que nous avons des LED T8 de remplacement pour les ampoules fluorescentes dans le laboratoire. En fait, ces lumières scintillent à 80 kilohertz », a déclaré Kutulakos. « Nous ne savions même pas que cela se produisait. »

Lors de la récente Conférence internationale sur la Computer Vision (ICCV) à Paris, l'article de l'équipe sur l'imagerie passive à photon unique à bande ultra-large a reçu un prix prestigieux, décerné seulement à deux articles parmi des milliers soumis par des experts en Computer Vision du monde entier.

Les applications potentielles de leur technique incluent de nouveaux types d’imagerie 3D et de systèmes lidar ainsi que l’imagerie scientifique, par exemple pour capturer des événements biologiques sur plusieurs échelles de temps ou pour l’observation astronomique de brèves impulsions lumineuses qui coïncident avec des sursauts radio rapides.

Des milliards d'images par seconde

Les humains considèrent la lumière comme une expérience continue : nous pouvons imaginer utiliser une caméra rapide pour capturer des séquences au ralenti. Si nous disposons de caméras de plus en plus rapides, nous pourrons peut-être simplement ralentir la lecture en continu.

« Mais à un moment donné, il y a un changement », a déclaré Lindell. « La lumière n'est pas continue, elle est discrète. Et nous capturons la lumière un photon à la fois. »

« Nous travaillons avec des capteurs à photons uniques depuis plusieurs années et le pipeline d'acquisition MATLAB dont nous disposons fonctionne toujours. C'est totalement fiable. »

Les diodes à avalanche à photon unique ne sont devenues plus largement disponibles dans le commerce qu'au cours de la dernière décennie. Le coût élevé de l'appareil signifiait que très peu de laboratoires d'informatique et de Computer Vision y avaient accès, a noté Kutulakos. Les récents développements en matière de capteurs ont incité l’équipe de l’Université de Toronto à poser de nouvelles questions sur des problèmes sur lesquels les scientifiques d’autres domaines travaillent depuis des décennies.

Par exemple, les astronomes spécialisés dans l’astronomie des rayons gamma, ont déployé des détecteurs pour détecter des particules individuelles et les horodater. Mais ces astronomes étaient plus intéressés par l'illumination périodique provenant d’étoiles variables que par la fonction exacte de variation dans le temps décrivant la luminosité des étoiles, puisque c'est ce que la physique exigeait, a expliqué Kutulakos.

Dans le laboratoire du Toronto Computational Imaging Group, le postdoctorant Sotiris Nousias et l'étudiant en doctorat Mian Wei ont d'abord utilisé un SPAD pour capturer des informations de synchronisation pour les photons provenant de diodes électroluminescentes.

« Nous avons fait clignoter les LED et avons examiné le flux de sortie », a déclaré Nousias. « Nous avons observé que le flux avait en fait le même pattern que le scintillement et avons ensuite travaillé pour trouver le lien mathématique. C'est ce qui nous a inspiré pour ce projet. »

Nousias et Wei, co-auteurs principaux de l’article de l’ICCV, se sont demandés quelles informations ils pourraient obtenir s’ils avaient accès à tous les photons. Les scientifiques ont tendance à utiliser les SPAD de manière spécialement synchronisée. Au lieu de cela, l’équipe a fait fonctionner le capteur en mode asynchrone. À partir de là, les chercheurs ont investiguer pour relier les arrivées discrètes de photons à une fonction continue sous-jacente qui décrit l’intensité variable de la lumière dans le temps.

« Nous collectons passivement des photons et essayons de reconstituer la contribution de toutes les sources lumineuses dans l’environnement, que la variation d’intensité soit rapide ou lente », a déclaré Kutulakos.

Dans une configuration expérimentale, l’équipe a capturé différentes lumières simultanément, puis les a lues à différentes vitesses. Le SPAD a observé un seul point sur une surface blanche. La lumière provenant d’un laser pulsé stroboscopique de 3 mégahertz, d’un laser pulsé stroboscopique de 40 mégahertz et d’un projecteur laser à balayage matriciel passait à travers un diffuseur et touchait le point blanc. Une ampoule intelligente brillait au-dessus de nos têtes.

Ils ont extrait un flux d’informations temporelles de la caméra indiquant le moment où un photon a frappé le capteur et ont extrait des informations d’intensité. L’équipe a utilisé MATLAB pour orienter le faisceau et obtenir une image, pour assurer l’alignement des pixels dans le temps et pour automatiser l’ensemble de l’acquisition des données.

« Nous travaillons avec des capteurs à photons uniques depuis plusieurs années et le pipeline d'acquisition MATLAB dont nous disposons fonctionne toujours », a déclaré Lindell. « C'est totalement fiable »

Plus précisément, ils se sont appuyés sur Image Processing Toolbox™, Computer Vision Toolbox™, Signal Processing Toolbox™, Data Acquisition Toolbox™ et Parallel Computing Toolbox™ pour le projet. Nousias a ajouté qu'ils ont également créé une interface graphique personnalisée pour contrôler les miroirs de balayage dans certaines de leurs expériences.

Il s’avère que les SPAD modernes peuvent réaliser bien plus d’imagerie computationnelle que ce que les chercheurs avaient imaginé auparavant.

« Nous n’aurions jamais pensé pouvoir voir les impulsions laser scintiller de manière asynchrone dans l’environnement », a déclaré Kutulakos.

Dispositif expérimental permettant de capter plusieurs sources lumineuses sur un seul point d'une surface blanche. (Crédit : Université de Toronto)

Zoom sur le temps

La reconstruction réalisée par l'équipe leur a permis de se concentrer sur des fréquences d'échantillonnage d'une seconde provenant du scintillement du projecteur laser et de descendre jusqu'à près de neuf ordres de grandeur, soit jusqu'à une impulsion individuelle à l'échelle de la nanoseconde provenant du laser de 3 mégahertz. Leur méthode leur a également permis de recréer une vidéo diffusée sur un projecteur TV laser qui n’était pas dans la ligne de mire. Dans ce cas, il s'agissait du lion rugissant classique en noir et blanc de la Metro Goldwyn Mayer recréé à partir du simple signal de balayage raster.

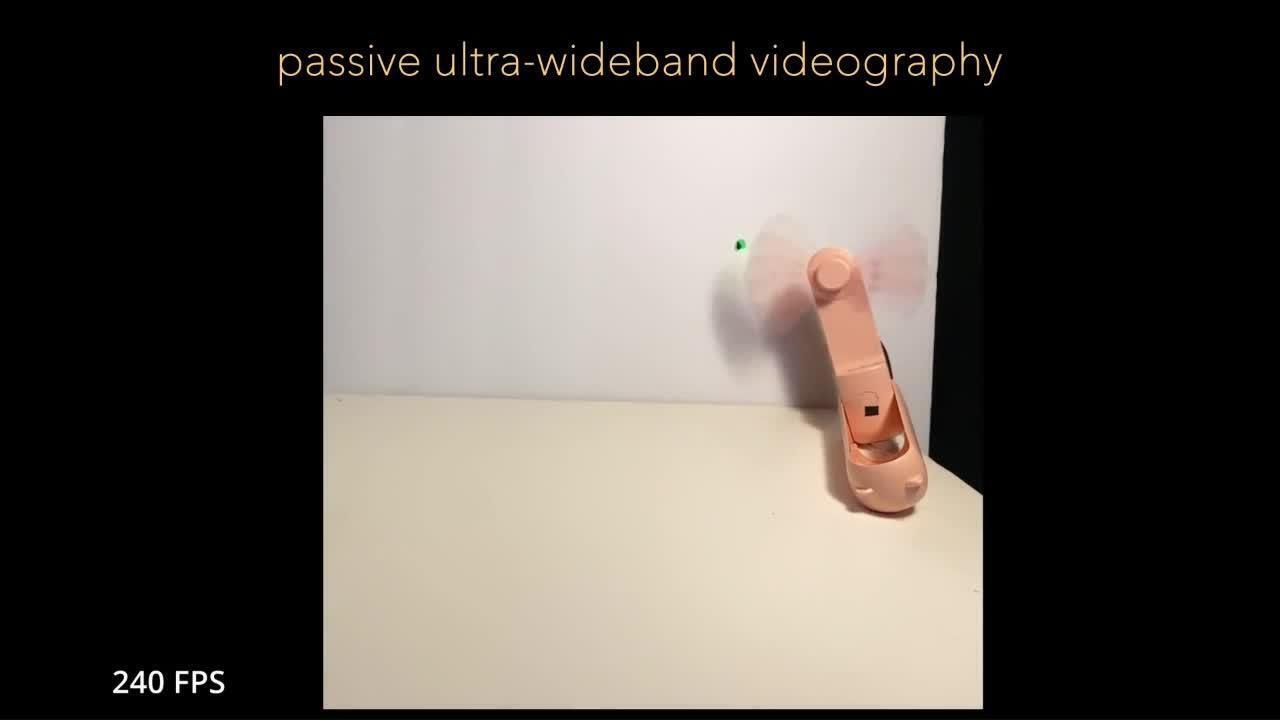

Une autre configuration présentait un ventilateur portatif rose pâle, à piles, sur un fond blanc. Pour démontrer la vidéographie passive à bande ultra-large, ils ont éclairé le ventilateur en rotation avec des impulsions laser. Contrairement aux techniques d’imagerie active qui floutent le ventilateur, leur technique fige clairement les pales du ventilateur se déplaçant à une échelle de temps différente de celle de la lumière stroboscopique. L’environnement reste toujours visible à l'échelle du gigahertz alors qu'un front d'onde rouge balaie les pales de ventilateur apparemment gelées.

« Lorsque vous obtenez un nouvel équipement, si vous ne disposez pas du support nécessaire pour effectuer l'interfaçage, vous devez alors exploiter différentes interfaces graphiques pour obtenir les données souhaitées. MATLAB nous a fourni un moyen pratique de contrôler tous les composants pour réaliser l'acquisition de données. »

« Considérez-cela comme une caméra vidéo très rapide », a déclaré Nousias. « Avec un appareil photo mobile, vous prenez un instantané. Mais dans notre cas, nous prenons un instantané d’un instantané d’un instantané. Nous naviguons à toute vitesse dans le temps. »

L’équipe connaissait déjà MATLAB lorsqu’elle a commencé à utiliser l’équipement d’imagerie pour le projet il y a huit ans. « Tous les outils sont très faciles à intégrer et nous offrent un accès rapide aux données », a déclaré Nousias. « Si quelque chose ne va pas et que nous devons ressaisir les données, elles sont faciles à visualiser et cela nous fait gagner du temps. »

Wei a également apprécié le support de MATLAB. « Lorsque vous obtenez un nouvel équipement, si vous n'avez pas le support nécessaire pour effectuer l'interfaçage, vous devez alors exploiter différentes interfaces graphiques pour obtenir les données souhaitées », a-t-il déclaré. « MATLAB nous a fourni un moyen pratique de contrôler tous les composants pour réaliser l'acquisition de données. »

Lindell était d’accord. « Le matériel que nous utilisons est assez hétérogène. Nous avons construit une interface de programmation unique à partir de bibliothèques existantes », a-t-il déclaré. « Si nous n'avions pas MATLAB, nous serions obligés de nous débrouiller avec différentes bibliothèques ou extensions tierces que les gens essayaient de créer dans d'autres langages de programmation. »

La vidéographie passive à bande ultra-large fige les pales du ventilateur en mouvement à une échelle de temps différente de celle de la lumière stroboscopique. Les pales restent visibles près de l'échelle du gigahertz tandis qu'un front d'onde rouge balaie les pales du ventilateur apparemment gelées. (Crédit : Université de Toronto)

Wei a estimé que, sans accès au logiciel informatique technique, l’intégration de chaque nouveau composant pourrait prendre des jours, voire des semaines. « Vérifier à nouveau que les composants fonctionnent comme prévu ajouterait encore plus de temps », a-t-il déclaré.

« Grâce à nos configurations, nous pouvons dire : « OK, j'ai cette nouvelle machine sous Windows®. Je vais prendre le code qui a fonctionnait auparavant, puis je vais le transférer » », a poursuivi Wei. « Désormais, quelqu’un d’autre peut utiliser ce code et faire fonctionner le système également. »

Possibilités d'imagerie dynamique

Recevoir un prix pour le meilleur article lors de la Conférence internationale sur la Computer Vision a représenté une réussite professionnelle majeure pour les chercheurs du Toronto Computational Imaging Group. Les organisateurs de la conférence n'ont sélectionné que deux articles parmi les 8 068 soumis, a déclaré Lindell.

« À une époque où le Deep Learning domine les conversations, cela nous rappelle qu’il existe toujours un besoin en recherche, pour nous aider à comprendre les phénomènes physiques de base et comment nous pouvons détecter ces phénomènes à l’aide de technologies émergentes », a-t-il déclaré.

« Je pense qu'il y aura des résultats que nous n'avions pas anticipés lorsque nous pointerons cette caméra autour du laboratoire ou même à l'extérieur. J'ai hâte de voir ce que nous allons trouver. Ce sera une nouvelle façon de conquérir le monde. »

Les chercheurs espèrent que leur découverte inspirera de nouvelles avancées. Un domaine propice à l’exploration est le lidar flash, une technique qui produit une image en profondeur de haute résolution à partir d’un laser pulsé diffus plutôt qu’à partir d’un laser pulsé à balayage. En général, cela implique d’envoyer de la lumière dans l’environnement, de mesurer le temps nécessaire à cette lumière pour revenir et d’utiliser ces informations de temporelles pour mesurer la distance.

« L’un des inconvénients est que vous devez synchroniser votre source lumineuse avec votre système pour que ce mécanisme fonctionne », a expliqué Wei. « Étant donné notre capacité à mesurer les signaux de manière asynchrone, nous souhaitons comprendre si nous pourrions utiliser une source de lumière asynchrone pour réaliser un lidar flash. »

En biologie, des événements tels que le pliage ou la liaison des protéines peuvent se produire sur des échelles de temps allant de quelques nanosecondes à quelques millisecondes. Lindell a déclaré que l’équipe avait discuté de ses techniques d’imagerie avec des experts en biologie de l’université.

« Le fait que ces événements se produisent à ces échelles de temps est intéressant pour nous, et la possibilité de les observer d'une manière inédite jusqu'à présent est séduisante », a-t-il déclaré.

La recentrage informatique pourrait avoir des applications dans d’autres sciences. Les astrophysiciens cherchent à comprendre ce qui cause les sursauts radio rapides (FRB) depuis qu'un radiotélescope a détecté le phénomène pour la première fois il y a 20 ans. Ces mystérieuses explosions d'énergie se produisent dans le ciel et ne durent que quelques millisecondes, mais chacune d'entre elles est incroyablement puissante. La recentrage informatique pourrait permettre la détection de FRB dans le domaine optique.

« Nous ne savons pas quand cela se produira », a déclaré Nousias. « Il faut surveiller le ciel, puis revenir aux données à l’échelle de la nanoseconde pour les observer. Nous disposons désormais de l’outil pour y parvenir. »

Kutulakos prévoit que sa méthode SPAD pourrait aider à détecter des problèmes ou des défauts dans les composants mécaniques conçus que les inspections standard ne détectent pas. Lorsqu'un moteur rencontre des soucis, les vibrations peuvent indiquer un problème, mais la source exacte peut s'avérer difficile à déterminer sans plus d'informations. En dirigeant une caméra vers le moteur et en collectant toutes les données, vous pourriez trouver cette aiguille dans une botte de foin, a-t-il déclaré.

Le groupe collabore également avec d’autres chercheurs en microélectronique pour étendre les possibilités des caméras. Une caméra à un seul pixel permet à l’équipe de produire des vidéos à partir de mouvements répétitifs, tels que des pales de ventilateur en rotation, mais les événements véritablement dynamiques nécessitent un capteur 2D.

Ensuite, l’équipe prévoit de travailler à l’amélioration de sa technique. La reconstruction des signaux reste assez longue et inefficace en termes de calcul, a noté Lindell. Ils travaillent donc à capturer des événements sur toutes les échelles de temps en temps réel.

« Je pense qu'il y aura des résultats que nous n'avions pas anticipés lorsque nous pointerons cette caméra autour du laboratoire ou même à l’extérieur », a déclaré Lindell. « J’ai hâte de voir ce que nous allons découvrir. Ce sera une nouvelle façon de conquérir le monde. »

Lire d'autres articles

IA

Accélérer la découverte scientifique grâce à la microscopie assistée par l'IA

Traitement d'images convivial et informations issues d'ensembles de données volumineux de type Lightsheet

TRAITEMENT D'IMAGES

À la découverte du plus grand écosystème du monde, à 500 mètres sous la surface de l'océan

Nat Geo développe une caméra robotisée sous-marine pour explorer les profondeurs