perceptron

Classifieur binaire simple à couche unique

Description

Remarque

Deep Learning Toolbox™ supporte les perceptrons pour leur intérêt historique. Pour de meilleurs résultats, vous devez utiliser à la place patternnet, qui peut résoudre des problèmes non linéairement séparables. Le terme « perceptron » fait parfois référence à des réseaux de reconnaissance de formes feedforward, mais le perceptron d’origine, décrit ici, peut seulement résoudre des problèmes simples.

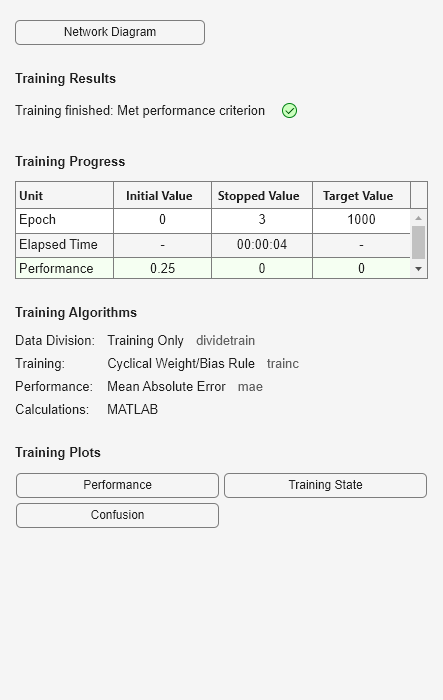

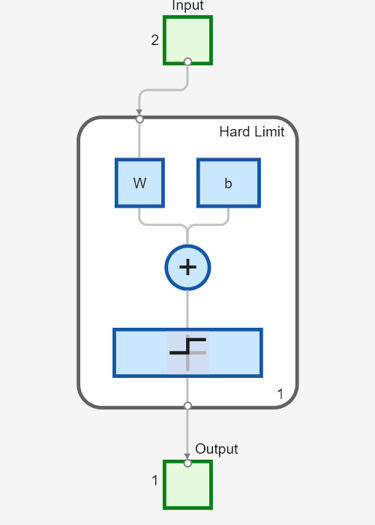

perceptron( prend une fonction de transfert aux limites strictes, hardlimitTF,perceptronLF)hardlimitTF, et une règle d’apprentissage du perceptron, perceptronLF, et renvoie un perceptron.

Outre la fonction de transfert aux limites strictes par défaut, les perceptrons peuvent être créés avec la fonction de transfert hardlims. L’autre option pour la règle d’apprentissage du perceptron est learnpn.

Les perceptrons sont des classifieurs binaires simples à couche unique qui divisent l’espace d’entrée avec une limite de décision linéaire.

Les perceptrons peuvent être entraînés pour résoudre une gamme restreinte de problèmes de classification. Ils ont été parmi les premiers réseaux de neurones capables de résoudre de manière fiable une classe donnée de problème. Leur avantage est une règle d’apprentissage simple.

Exemples

Arguments d'entrée

Historique des versions

Introduit dans R2010b

Voir aussi

preparets | removedelay | patternnet | timedelaynet | narnet | narxnet